はじめに

Data Factoryなどデータ系のサービスは普段あまり利用することが少ないと思います。そこで、チュートリアルをもとにBlobからBlobへデータをコピーしてみたいと思います。

これは一見、ファイルをコピーしているように見えますがパイプラインによって「データ」をコピーしています。それによってさまざまデータに変換できます。Data Factoryと言われる理由です。

設定

以下の作業を行います。

- Blobの作成

- Data Factoryの作成

- データセットの設定

- 入力データセットの設定

- 出力データセットの設定

- パイプラインの作成

- デバック

- トリガー

- 手動

- スケジュール

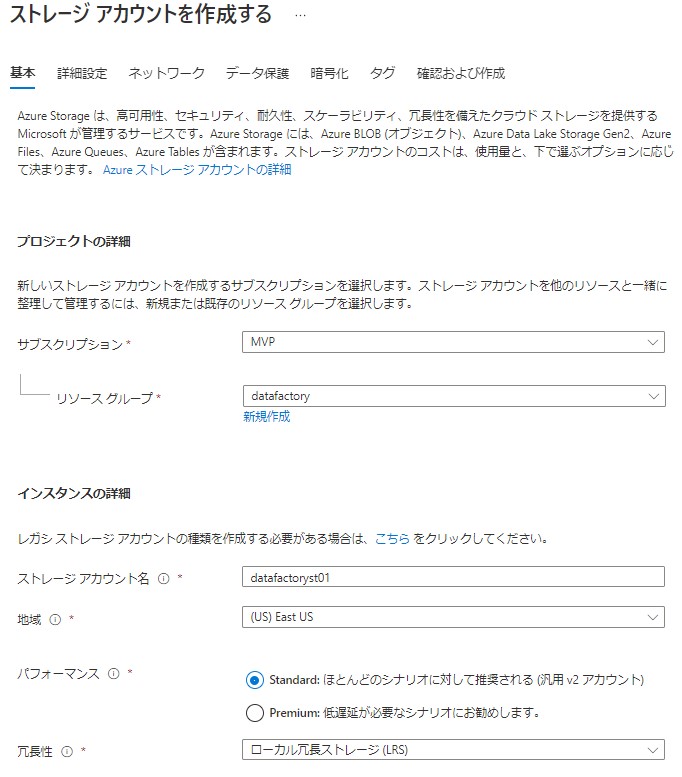

Blobの作成

ストレージアカウントを作成します。

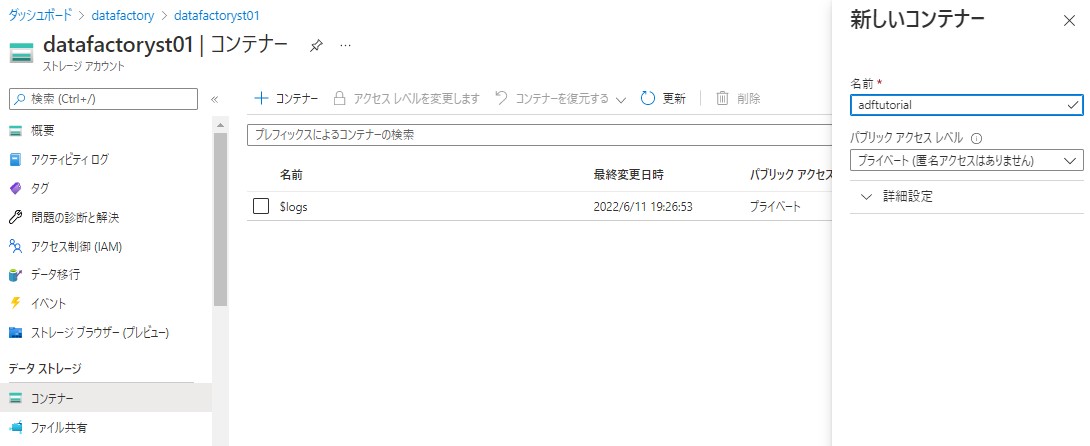

コンテナーを任意の名前で作成します。

- 名前:adftutorial (任意)

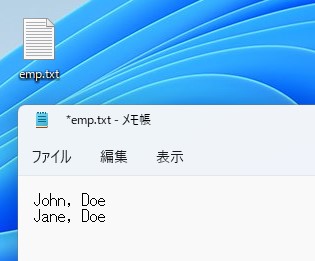

アップロードするファイルを用意します。

中身はどのようなものでも構いません。emp.txtと名前を付けます。

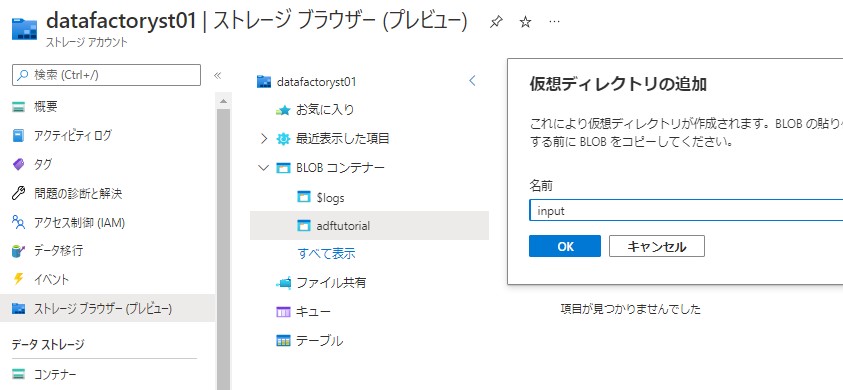

アップロードするコンテナーにディレクトリを作成します。方法は直接アップロードしても図のようにストレージブラウザでも構いません。inputというディレクトリを作成します。

作成したディレクトリにファイルをアップロードします。

Data Factoryの作成

Data Factoryの作成を行います。

- 名前:一意の値

- バージョン:V2

Gitは特に構成しないので、後で構成するにチェックを入れます。以上で作成します。

データセットの設定

入力、出力するファイルの場所であるデータセットを設定します。

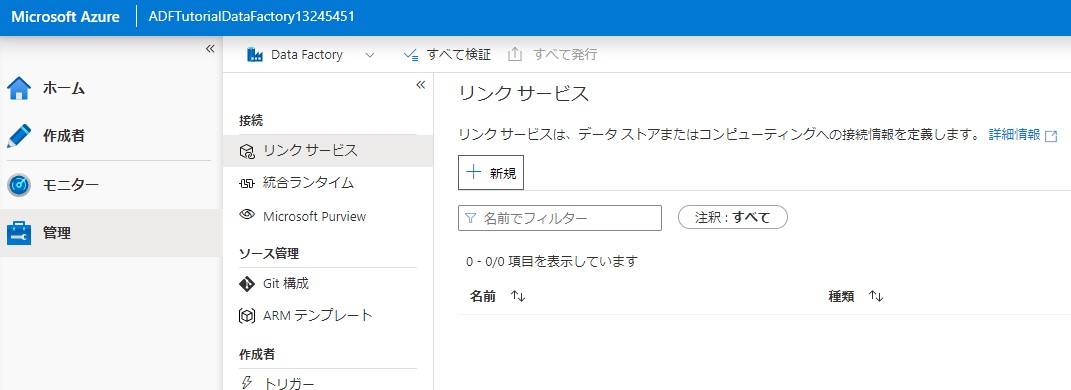

Azure Data Factory Studioを開きます。

最初に利用するデータストアをリンクサービスに追加します。

新規をクリックします。

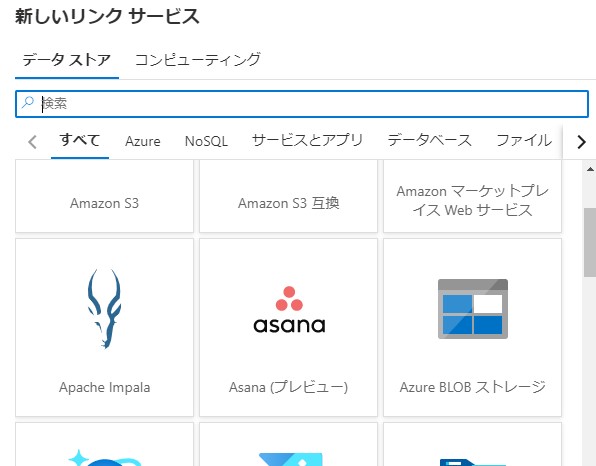

様々なデータストアと連携とれますが、今回はファイルをアップロードしたBlobを利用したいのでBlobストレージを選択します。

新しいリンクサービスを追加します。

- 名前:任意

- ストレージアカウント:上記で作成したストレージアカウント

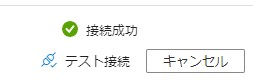

必要ならばテスト接続を行います。正常に接続できるか確認できます。

Input データセット

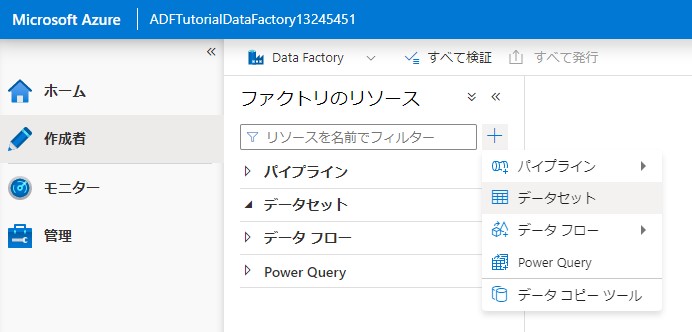

最初にinput データセットを設定します。

作成者から「+」をクリックしてデータセットを開きます。

利用するデータセットであるBlobストレージを選択し開きます。。

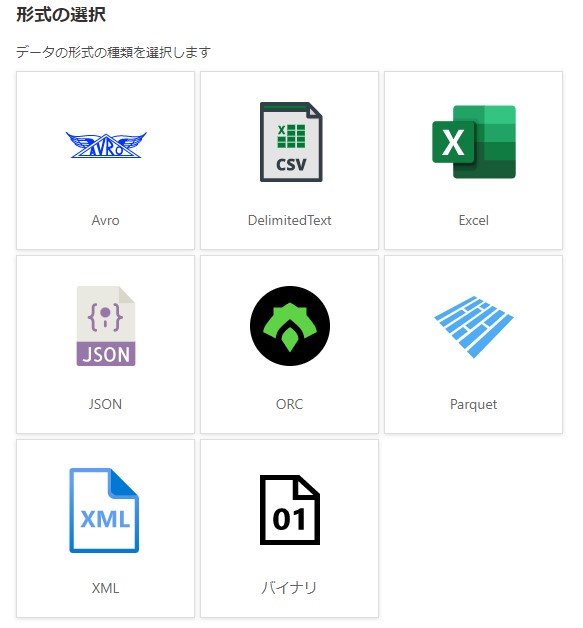

さらに、データの形式を設定します。

今回は、バイナリを選択します。これはデータを丸ごとコピーします。

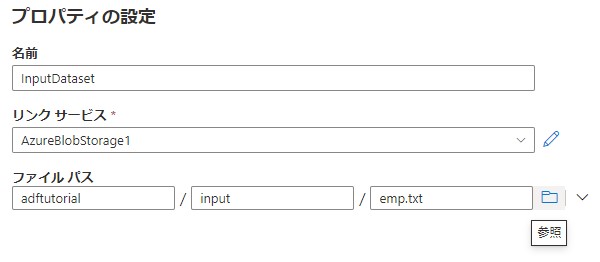

実際にコピーするファイルを設定します。

- 名前:任意

- リンクサービス:上記で設定したリンクサービス

- ファイルパス:アップロードしたファイルを参照します

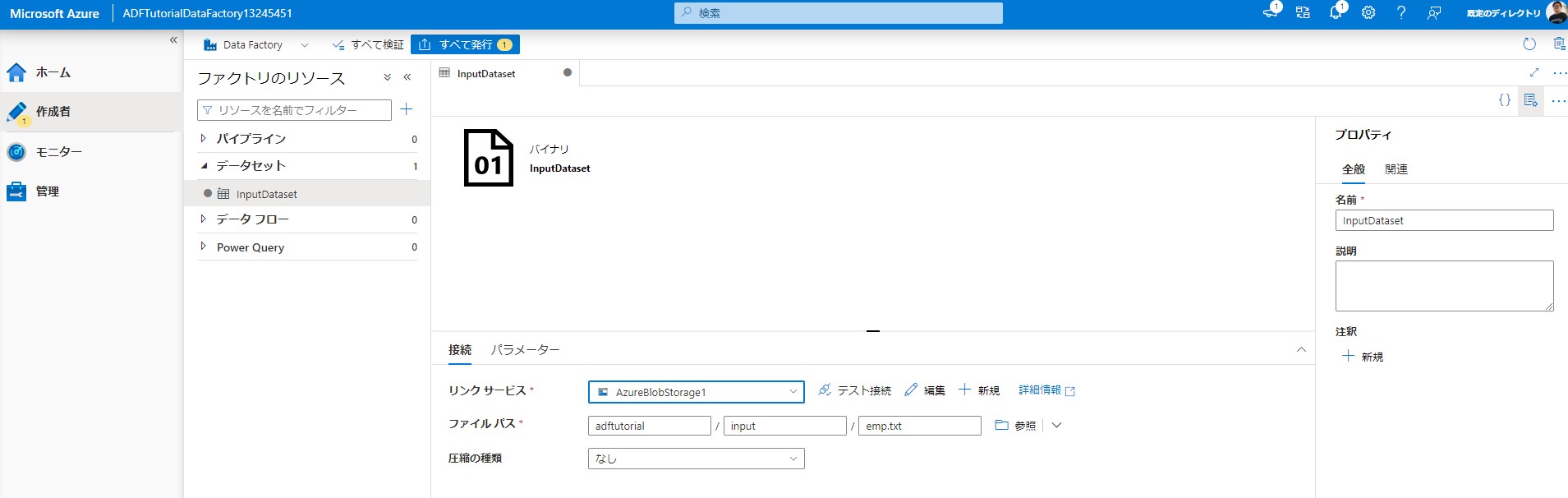

追加後、設定したデータセットを確認できます。

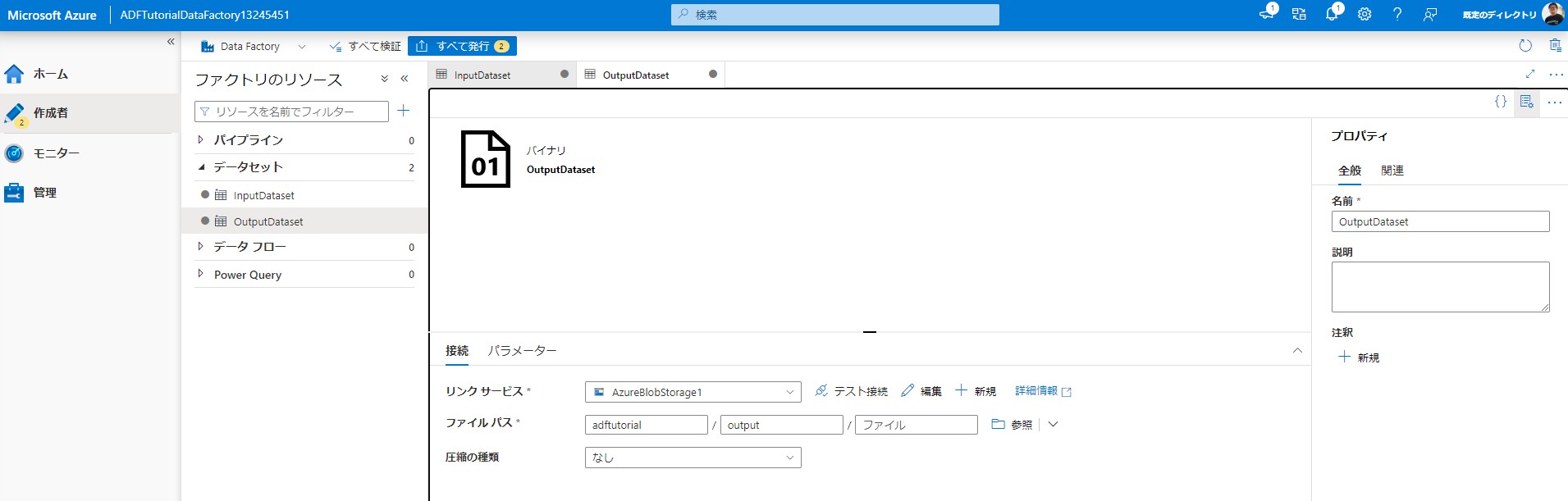

Output データセット

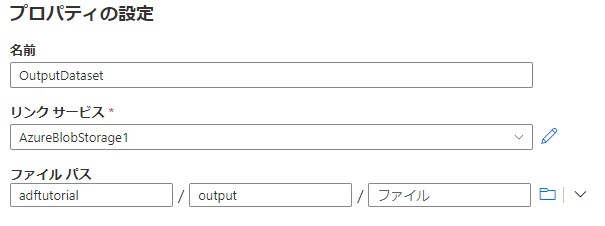

inputと同様にデータセットを追加します。

ファイルバスは、フォルダを指定します。ファイルは指定しません。ない場合は直に入力します。パイプライン実行時に作成されます。

追加後にOutput データセットを確認できます。

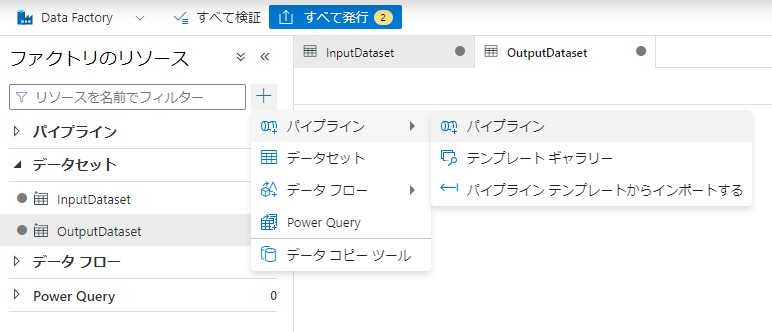

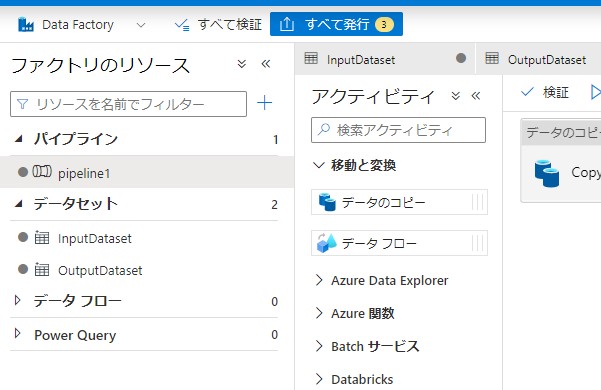

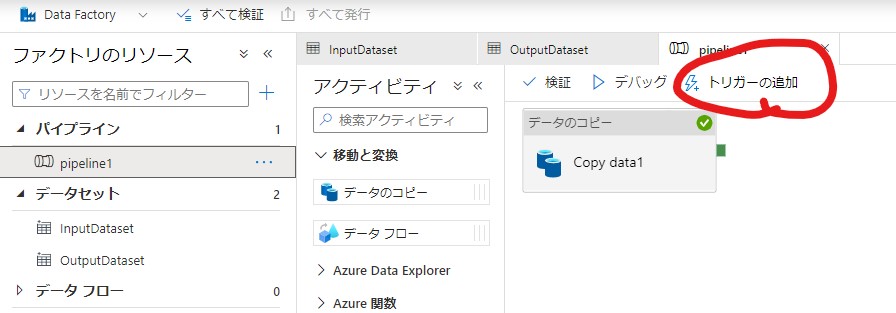

パイプラインの作成

「+」からパイプラインを開きます。

プロパティで名前を任意の値で設定します。

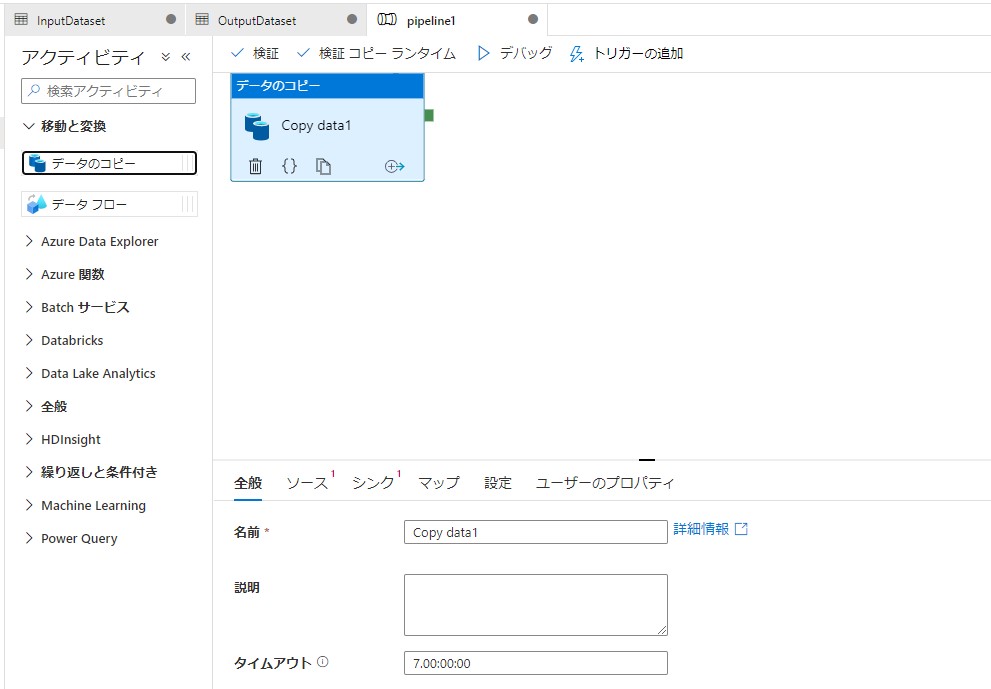

「データのコピー」をドラッグ&ドロップで右側に追加します。全般の名前に任意の値を設定します。

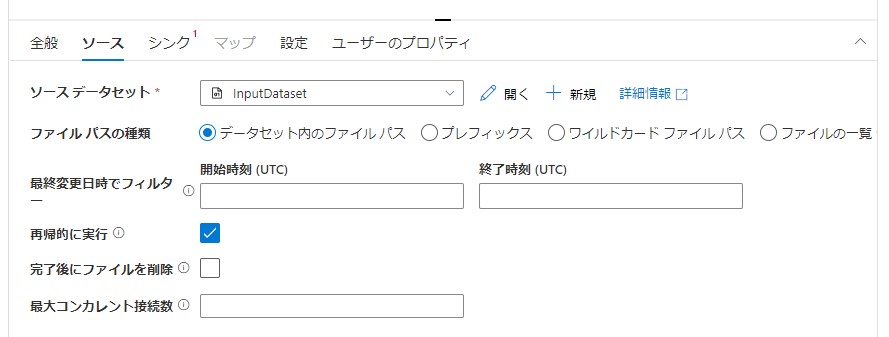

ソース(入力)を設定します。

ソースデータセットでInputデータセットを選択します。

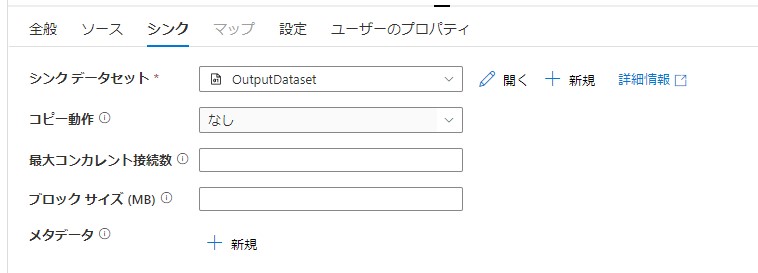

シンク(出力)を設定します。

シンクデータセットでOutputデータセットを選択します。

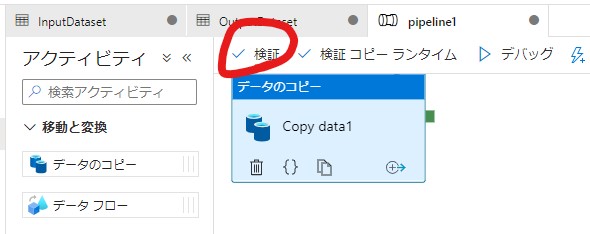

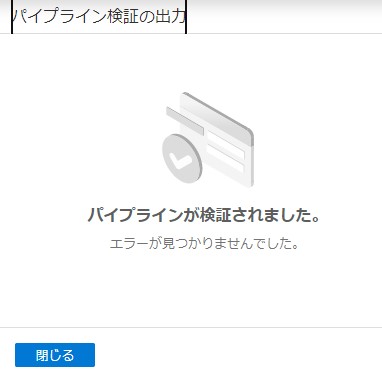

検証を行います。設定に問題があるか確認できます。

検証の結果が右側に表示されます。

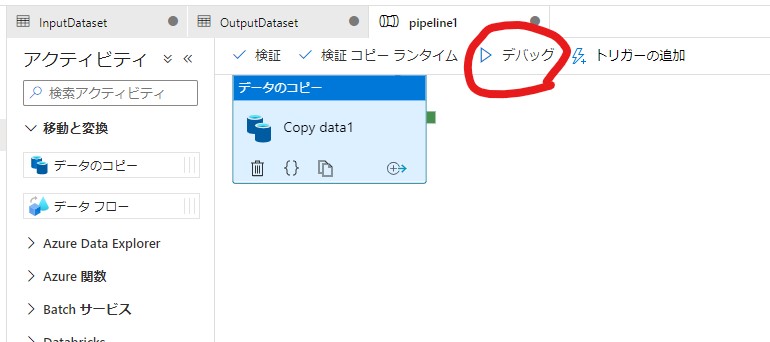

デバック

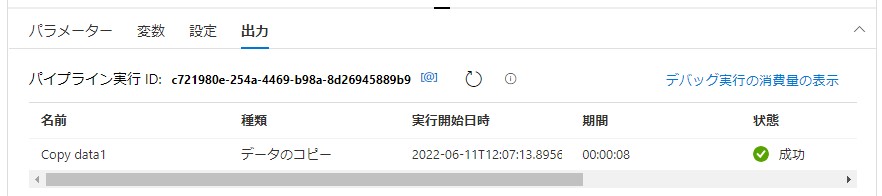

デバックをクリックすることで動作を確認します。

動作を確認できます。キューが入ります。

実行の成功を確認できます。

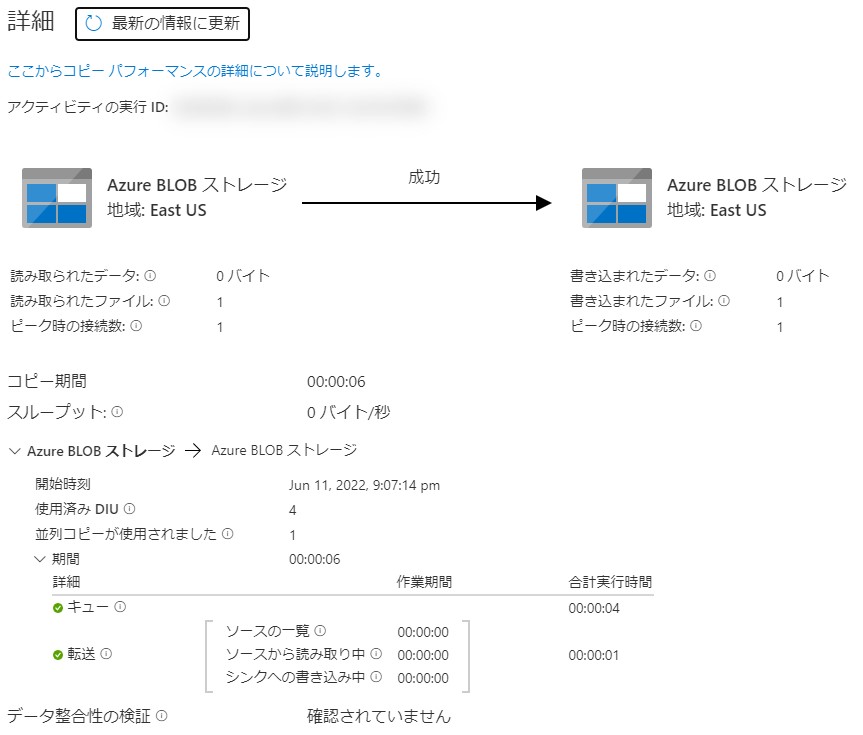

名前の横に表示されるメガネのアイコンをクリックして実行の詳細を確認することもできます。

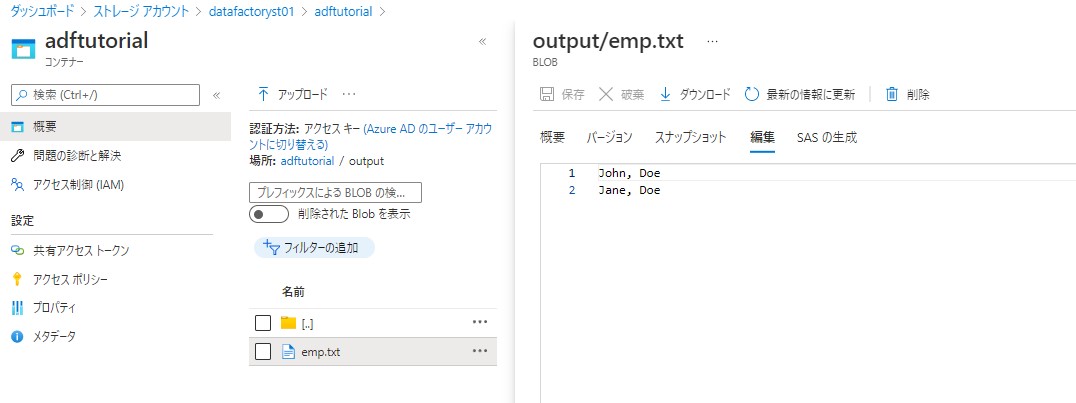

実際にデータがコピーされていることを確認できます。

すべてを発行します。要は保存し実行できるようにします。

トリガー

パイプラインを実行するには、トリガーを設定する必要があります。

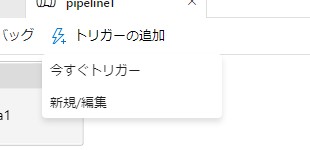

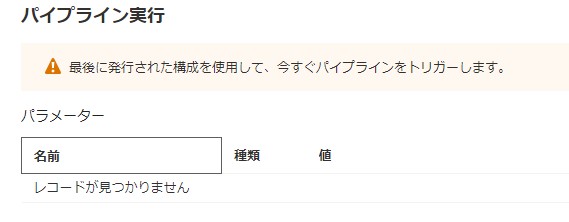

手動

手動でトリガーを実行する場合には「今すぐトリガー」を実行します。

実行します。

実行されることを確認します。

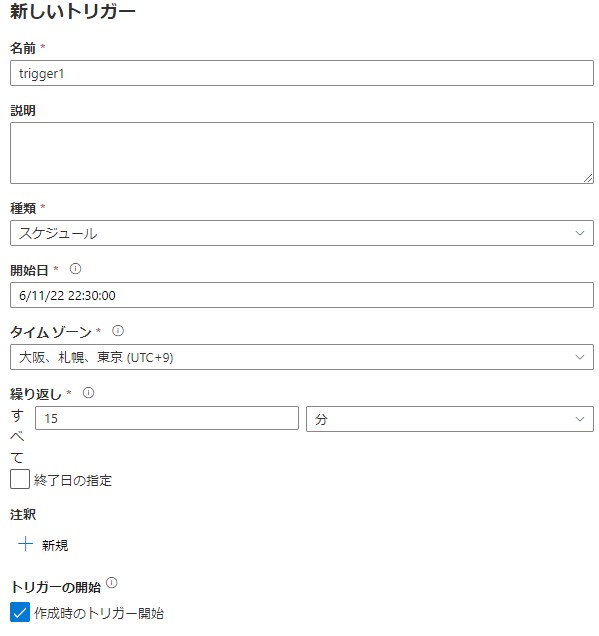

スケジュール

トリガーはスケジュールで設定も行えます。

- 名前:任意

- 種類:スケジュール

- 開始日:任意

- タイムゾーン:分かりやすい場所を指定

- 繰り返し:任意

- 作成時のトリガー開始

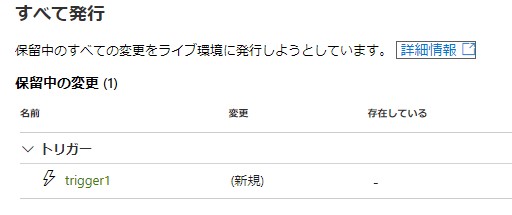

トリガーを保存します。ここで重要なのはトリガー作成後に発行を行います。

すべてを発行するを行った場合に、作成したトリガーが表示されることが確認できます。

実行確認

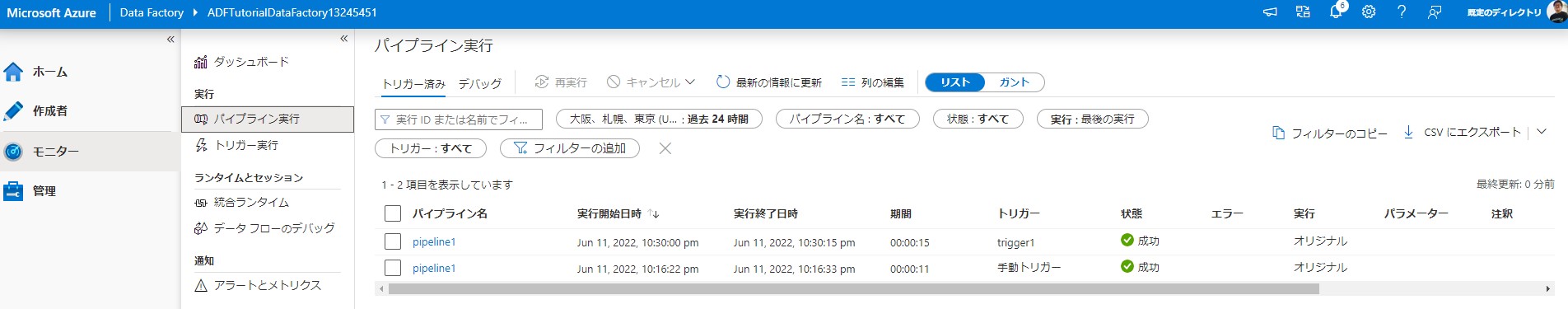

モニターのパイプライン実行を確認することができます。

まとめ

Data Factoryを実際に動かして確認しました。正直、データ系がドキュメントを読んだだけでは分かりにくいので手を動かして確認することをお勧めします。

そしてDP-900に合格しました。